6 ПРИЧИН – НАВІЩО ПОТРІБНИЙ ФАЙЛ ROBOTS.TXT

Індексація ресурсу пошуковими роботами – обов’язковий етап SEO просування. Файл robots.txt призначений для передачі їм рекомендацій щодо перегляду та додавання до індексу сторінок сайту.

Далеко не всі наповнення сайту підлягають індексації – поза увагою пошукових алгоритмів мають виявитися службові, технічні сторінки, дублі, а також контент із низькою частотою пошукового запиту. У robots.txt прописуються закриті для перегляду сторінки, а також даються різні службові вказівки для пошукових роботів Google та Яндекс.

ОСНОВНА РОЛЬ ROBOTS.TXT У SEO

Якщо розглядати роботу файлу robots.txt в цілому, то можна помітити відразу три великі завдання:

- заборона індексації допоміжних сторінок веб-ресурсу;

- дозвіл на доступ та допоміжні вказівки для сканування основних сторінок;

- розвантаження сервера за рахунок зміни часу індексування.

На окрему увагу заслуговує роль robots.txt в SEO. За рахунок скорочення завдань та відсутності не потрібної інформації, пошуковий бот може приділити більше уваги індексації нових даних, а значить допомагає:

- швидше залучити цільову аудиторію;

- збільшити релевантність;

- відстежити зміни позицій сайту

Використання файлу не є обов’язковим, тому для невеликих проектів можна використовувати інші рішення, наприклад, Sitemap або Host.

ЛЕГКО ТА ШВИДКО – ЯК СКЛАСТИ ПРАВИЛЬНИЙ ROBOTS.TXT

Роботу над новим файлом robots.txt зручніше вести в одному із простих текстових редакторів, наприклад, у Блокноті. Основне завдання всіх дій – усунути з індексації всю зайву чи конфіденційну інформацію та задати ботам чіткий алгоритм дій.

Складання інструкцій передбачає:

- стандартне звернення-директиву до пошукової роботи – User-agent;

- далі слідує ім’я робота, наприклад: YandexBot, Googlebot;

- якщо вказівка призначена всім ботів, то ставлять «*», якщо якийсь однієї системи, то вказують її назва;

- хештег «#» означає коментарі для ботів;

- завдання роботам прописують як директив: Disallow – заборона, Allow – дозвіл, Crawl-delay – зменшити швидкість обходу;

- інформацію записують як блоків, кожен із яких містить правила для певного бота;

Поєднання файлу robots.txt та SEO просування допомагає прискорити індексацію потрібних сторінок і тим самим вивести сайт на перші рядки видачі.

Правильний robots.txt для CMS WordPress

Ось що вийшло:

User-agent: * # загальні правила для роботів усіх пошукових систем

Disallow: /cgi-bin # службова папка для зберігання серверних скриптів

Disallow: /? # всі параметри запиту на головній

Disallow: /wp- # всі файли WP: /wp-json/, /wp-includes, /wp-content/plugins

Disallow: /wp/ # якщо є підкаталог /wp/, де встановлено CMS (якщо ні,

# правило можна видалити)

Disallow: *?s= # пошук по сайту

Disallow: *&s= # пошук по сайту

Disallow: /search/ # пошук по сайту

Disallow: /author/ # архів автора

Disallow: /users/ # архів користувачів

Disallow: */trackback # трекбеки, повідомлення в коментарях про посилання на веб-документ

Disallow: */feed # всі фіди

Disallow: */rss # rss фід

Disallow: */embed # всі вбудовування

Disallow: */wlwmanifest.xml # xml-файл маніфесту Windows Live Writer (якщо не використовуєте,

# правило можна видалити)

Disallow: /xmlrpc.php # файл WordPress API

Disallow: *utm*= # посилання з utm-мітками

Disallow: *openstat= # посилання з позначками openstat

Allow: */uploads # відкриваємо папку з файлами uploads

Allow: /*/*.js # відкриваємо файли скриптів js

Allow: /*/*.css # відкриваємо фали css

Allow: # дозволяємо індексувати зображення

Allow: # дозволяємо індексувати зображення

Allow: # дозволяємо індексувати зображення

Allow: # дозволяємо індексувати гіфки

Allow: /wp-admin/admin-ajax.php # дозволяємо ajax

# Вкажіть головне дзеркало сайту, як у прикладі нижче (з WWW / без WWW, якщо HTTPS

то пишемо протокол, якщо потрібно вказати порт, вказуємо). Команда стала необов'язковою. Раніше Host розумів

# Яндекс та Mail.RU. Тепер усі основні пошукові системи команду Host не враховують.

Host: www.site.ru

# Вкажіть один або кілька файлів Sitemap (дублювати для кожного User-agent

# не потрібно). Google XML Sitemap створює дві карти сайту, як у прикладі нижче.

Sitemap: http://site.ua/sitemap.xml

Sitemap: http://site.ua/sitemap.xml.gz

Перевірка robots.txt

Якщо файл robots.txt налаштований неправильно, це може призвести до множинних помилок в індексації сайту. Перевірити правильність налаштування вашого robots.txt можна за допомогою безкоштовного інструменту Google Robots Testing Tool

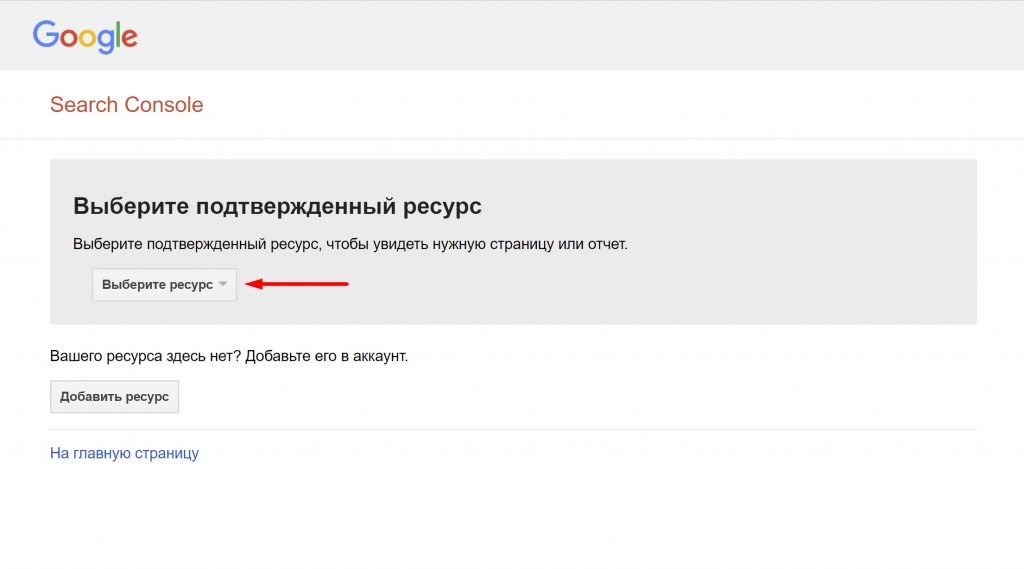

Вибираємо наш сайт:

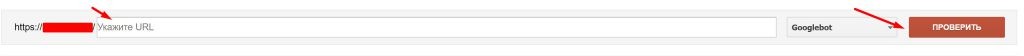

Вводимо в рядок шлях до нашого файлу robots.txt і натискаємо кнопку Перевірити:

В результаті не повинно бути помилок і попереджень і файл повинен бути доступний для роботів:

Якщо файл robots.txt правильно налаштований, це значно прискорить процес індексації вашого сайту.